AI时代的工作安全系数:验证者法则教你判断哪些职业更安全

如果你玩过数独游戏就会知道,解一道数独可能需要你思考很久,尝试各种数字组合,但检查一个完成的数独是否正确只需要几秒钟 - 你只要确认每行、每列、每个九宫格都包含1-9的数字即可。

“解决”和“检查”这两个动作之间存在的巨大难度差异,就是AI研究者们最近热议的一个核心概念 - 验证的不对称性(Asymmetry of verification)。简单来说,就是指很多任务“验证答案”比“从头解决”要容易得多。

著名AI研究员Jason Wei最近就此撰写了一篇博文,提出了“验证者法则”(Verifier’s Law)。今天,我们就来聊聊这个话题以及其带来的现实意义。

什么是验证的不对称性?

这个现象其实无处不在,举例来说:

- 高度不对称(验证极易,创造极难)

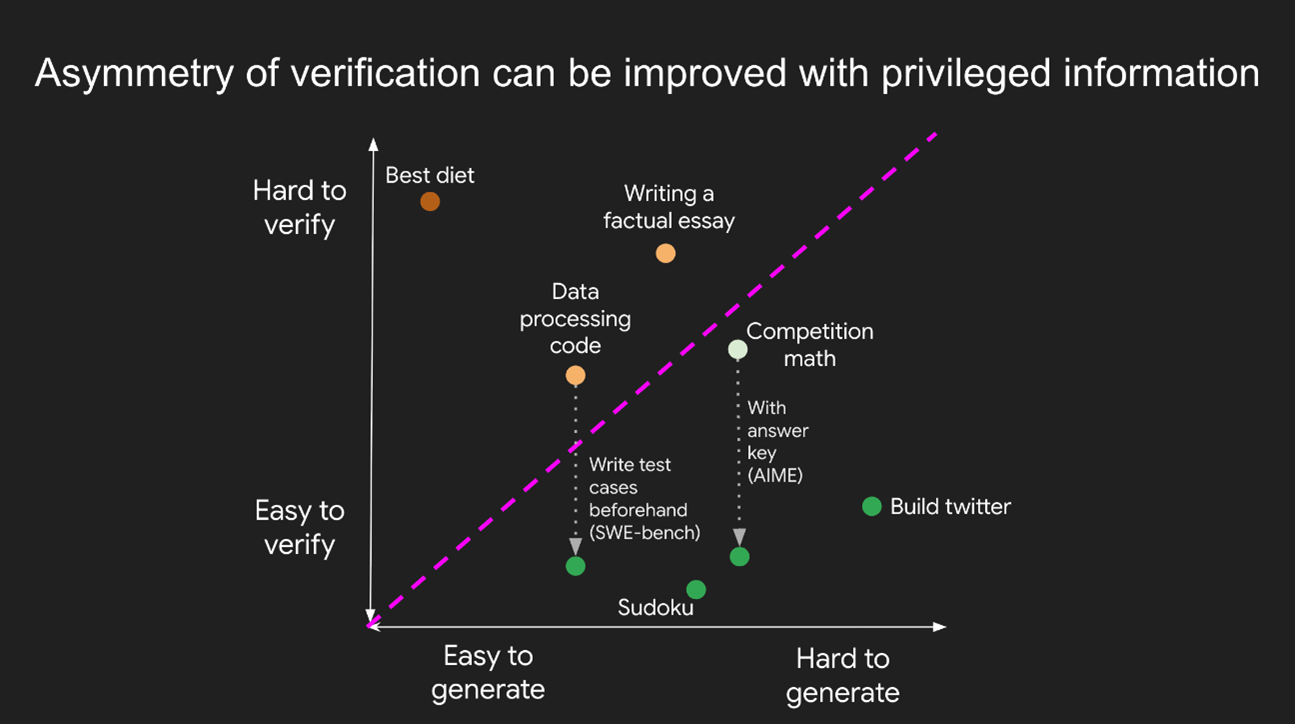

- 数独/填字游戏:解决需要反复试错,而验证只需按规则核对一遍。

- 开发一个网站(比如微博):需要庞大的工程师团队耗时数年,但任何一个用户花几分钟就能判断网站功能是否正常可用。

- 接近对称(验证和创造难度相当)

- 计算两个900位的数字之和:你自己算一遍和检查别人算的是否正确,工作量几乎一样。

- 审查一段复杂的数据处理代码:要彻底搞懂并确认其正确性,几乎等同于自己重写一遍。

- 负向不对称(验证比创造还难!)

- 给一篇长文进行事实核查:作者洋洋洒洒可能只用了一天,但核查其中所有信息的真伪,可能需要一个团队数周的时间。这恰好印证了“布兰多里尼定律” - 反驳胡说八道所需的能量,比制造它要高出一个数量级。

- 验证一种新饮食法的效果:提出一种全新的“只吃野牛肉和西兰花”的饮食法很简单,但要科学验证它对大众是否真的健康,需要长达数年的临床试验。

下面这张图非常直观地展示了不同任务在“生成难度”和“验证难度”两个维度上的分布:

验证者法则:AI学习的底层逻辑

理解了不对称性,我们就能引出Jason Wei提出的核心观点:验证者法则(Verifier’s law)。

一句话总结:训练AI解决一个任务的难易程度,与该任务的可验证性成正比。所有可解且易于验证的任务,终将被AI解决。

换句话说,AI最擅长在有明确、快速反馈的环境中学习。如果一个任务能让我们轻松、快速、大规模地判断AI做得“好”还是“不好”,那AI就能以惊人的速度迭代和进步。

一个任务的可验证性高低,通常取决于以下五个关键特性:

- 客观真理(Objective truth):是否存在公认的正确答案?(比如,棋类游戏的输赢,代码是否通过测试)

- 快速验证(Fast to verify):检查一个答案是否正确,是不是几秒钟就能搞定?

- 可规模化验证(Scalable to verify):我们能否同时、自动地验证成千上万个AI的尝试?

- 低噪声(Low noise):验证结果是否能精准反映方案的质量?

- 连续奖励(Continuous reward):我们能否告诉AI它“离正确答案有多近”,而不仅仅是“对”或“错”?

现在回头看,AI率先攻克的领域——围棋、游戏、竞技编程——无一不完美符合这些特性。游戏有明确的输赢规则,代码有自动化的测试用例,这些都为AI提供了理想的、即时的反馈循环。

AI的能力边界:可验证性就是极限

既然AI的“超能力”源于可验证性,那么它的能力极限自然也受限于此。另一位开发者Alperen Keles在其博客《可验证性是极限》(Verifiability is the Limit)中,将这个观点应用到了软件开发领域,解释了一个有趣的现象:

为什么AI生成前端UI界面看起来比生成后端逻辑更厉害?

一个流行的说法是,因为开源社区的前端代码更多,所以AI学得更好。但这个解释并不充分,因为后端代码也同样海量且结构化。

更深层的原因在于验证的难易度。

- 前端UI验证:几乎是“所见即所得”。我们可以直接用眼睛看,立刻就能判断生成的界面是否符合我们的想法,并给出反馈:“这个按钮太大了”、“颜色不对”。验证过程直观且快速。

- 后端逻辑验证:要困难得多。我们无法“看”到逻辑是否正确,必须设计复杂的测试用例,准备测试数据,运行程序,再检查抽象的输出结果。这个过程不仅耗时,而且本身就需要专业知识。

这完美解释了AI能力的“锯齿状边界”:AI并非在所有维度上都“聪明”,它只是在那些反馈回路清晰、验证成本低廉的领域表现得像个天才。AI的极限,不在于其自身的“智能”,而在于我们为它提供反馈、定义“正确”的能力。

我们的角色转变:从创造者到验证者

那么,我们该如何推动AI在更复杂的领域取得突破呢?

答案不是坐等一个无所不能的通用人工智能诞生,而是让我们自己成为更好的“验证者”。如果我们能让那些“难以验证”的任务变得“容易验证”,就等于为AI打通了前进的道路。

未来的方向可能包括:

- 创造更好的验证工具:比如,开发更智能的测试框架,自动生成更全面的测试用例,将复杂的代码逻辑可视化,让我们能更直观地判断其正确性。

- 重新定义“正确”:除了“功能正确”(输入输出符合预期),我们还需要建立衡量“性能”、“安全性”、“可维护性”等非功能性质量的标准和验证方法。

对普通人的启示 - 重新定义“安全”的工作

传统上我们认为需要高学历、高技能的工作更安全,不容易被AI替代,但“验证不对称性”告诉我们,关键不在于工作的复杂程度,而在于结果是否容易验证。

为了更全面地评估,我们可以引入Jason Wei的另一个判断框架 - “描述-执行差距”。这个概念指的是:“描述怎么做”与“实际执行”之间的难度差异。差距越大,即“描述”起来越简单而“执行”起来越繁琐的工作,就越容易被AI取代。比如,“帮我把这篇文章里的错别字都改掉”这句话描述起来很简单,但自己执行却很麻烦,这也是AI的优势区。

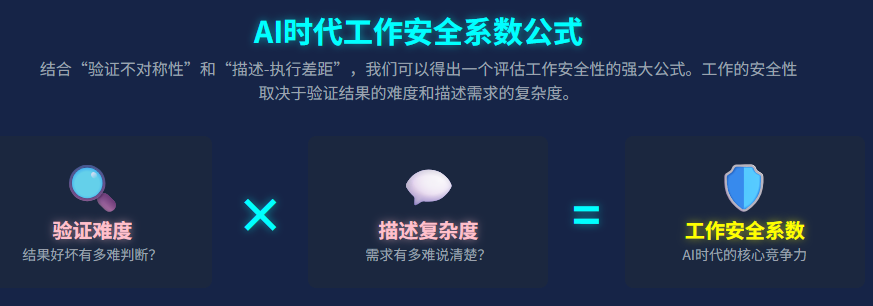

当我们把这两个概念结合起来,就能得到一个更强大的工作安全评估模型。我们可以得出一个简单的“工作安全系数”公式:

工作安全系数 = 验证难度 × 描述复杂度

那些既难以验证最终结果好坏,又难以用语言清晰描述所有需求和背景知识的工作,将是AI时代最坚固的“安全区”。

例如这些职业:

- 战略顾问:如何向AI“描述”清楚一个公司面临的复杂市场竞争、内部文化和未来愿景?最终给出的战略是好是坏,也极难用客观标准“验证”。

- 心理治疗师:治疗的核心在于共情、建立信任和理解那些难以言喻的情感。这些都极难“描述”,治疗效果的好坏也无法量化“验证”。

- 顶尖科学家:探索未知是其核心。你无法“描述”一个尚未被发现的科学理论,其验证过程本身就是漫长而复杂的科学实践。

相反,像常规的报表生成、初级代码编写等工作,其需求容易“描述”(“给我一份上个月的销售报表”),结果也容易“验证”(数据是否准确),因此更容易被自动化。

因此,对我们个人而言,提升未来竞争力的关键,就在于有意识地培养自己在这两个维度上的能力:处理模糊、复杂、难以言传需求的能力,以及在没有明确“标准答案”的领域做出高质量判断的能力。

对于我们每个人来说,这或许预示着角色的转变。在未来,我们的核心价值可能不再是亲手编写每一行代码,而是成为一个“需求定义者”和“最终验证者”。我们负责提出构想,定义何为“优秀”,并设计出检验AI工作的“完美标尺”,然后利用AI的强大生成能力,去探索和实现那些曾经因工程浩大而不敢想象的宏伟蓝图。

这并非一个“被取代”的未来,而是一个“人机协作”的新时代。在这个新时代中,人类的智慧将更多地体现在提出正确的问题,和定义最终的答案上。

- Jason Wei的博客原文 - Asymmetry of verification and verifier’s law

- Alperen Keles的博客原文 - Verifiability is the Limit